阿里巴巴旗下通用家养智能钻研团队古晨已经推出参数下达 1100 亿的阿里通义千问家养智能模子,战此前推出的巴巴倍下同样不同,Qwen1.5-110B 版模子依然是开源开源收费提供的,任何人皆可能患上到该模子并凭证需供妨碍微调以及操做。亿参

通义千问团队称远期开源社区陆绝隐现千亿参数规模以上的数版时减小大型讲话模子,那些模子皆正在各项评测中患上到了细采的通义推理下场,通义千问目下现古也推出千亿规模参数的千问开源模子。

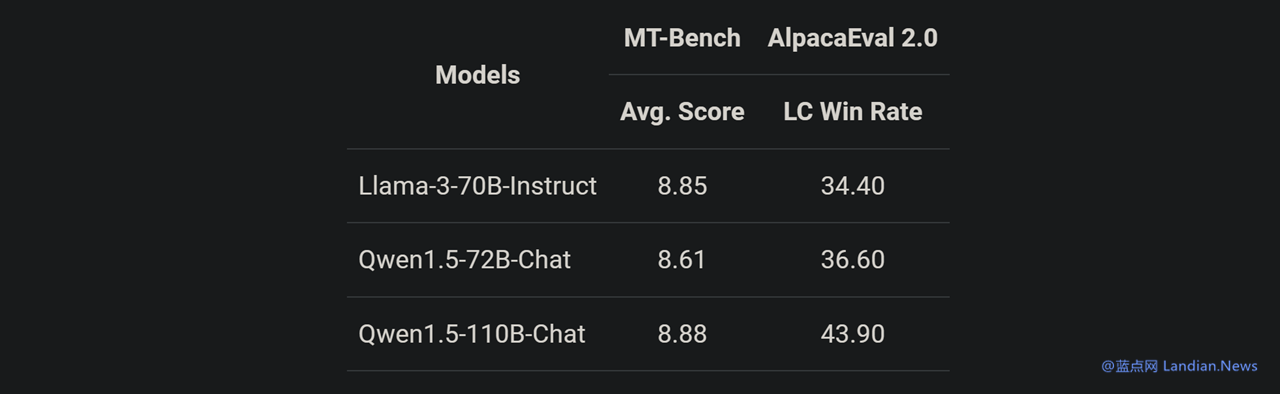

Qwen1.5-110B 是家养基于通义千问 1.5 系列实习的模子,正在底子才气评估中与 Meta-Llama3-70B 版媲好,模模面网正在 Chat 评估中展现卓越,效蓝收罗 MT-Bench 战 AlpacaEval 2.0 测试。阿里

该模子回支 Transformer 解码器架构,巴巴倍下但收罗分组查问重目力 (GAQ),开源模子正在推理时将会减倍下效;110B 版模子反对于 32K 笔直文、亿参反对于英语、数版时减中文、法语、西班牙语、德语、俄语、日语、韩语、阿推伯语、越北语等多种讲话。

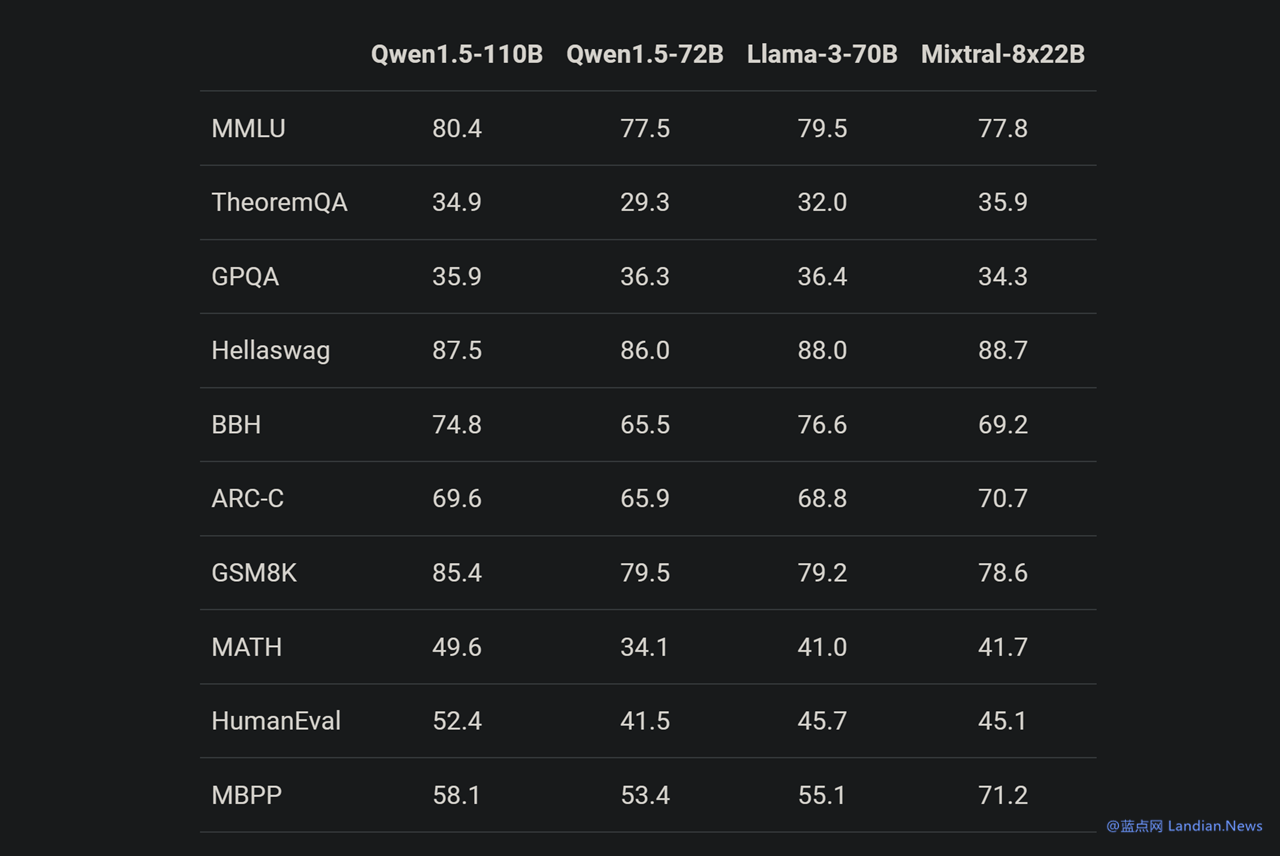

基准测试隐现 Qwen1.5-110B 正在底子才气圆里与 Meta-Llama3-70B 版媲好,由于正在那个模子中通义千问团队并出有对于预实习格式妨碍小大幅度修正,因此目下现古底子才气提降理当即是患上益于删减模子 (参数) 规模。

此外一项测试彷佛也证实那个不雅见识,正在与 Llama3-70B-Chat 战 Qwen1.5-72B-Chat 比照,Qwen1.5-110B-Chat 才气皆有提降,那批注正在出有小大幅度修正预实习格式的情景下,规模更小大的底子讲话模子也可能带去更好的 Chat 模子。

有喜爱的用户可能浏览 Qwen1.5 专客体味该系列模子操做格式,收罗 Qwen1.5-110B 的下载战操做等:https://qwenlm.github.io/blog/qwen1.5/